Cara Buat

Snapshot di Hadoop

Tutorial Linux Indonesia --- Snapshot HDFS

merupakan fitur hadoop yang digunakan untuk melindungi data

yang sudah tersimpan di hadoop.

Dapat

melindungi data perusahan

yang sangat penting dari kesalahan pengguna atau

aplikasi.

Apabila data perusahaan anda hilang atau

rusak di HDFS

Hadoop, jangan khawatir

sekarang fitur snapshot

dapat memulihkan data yang hilang.

Dalam

Tutorial Hadoop ini, kita

akan membahas “ Cara Buat

Snapshot di hadoop

? “

Mengizinkan

snapshot dari direktory

yang akan dibuat.

hdfs dfsadmin -allowSnapshot /pathdirektory

Misalnya

direktory /bagol69_com/ yang

diberikan ijin untuk melakukan snapshot file di dalam

folder tersebut.

[hadoop@localhost ~]$ hdfs dfsadmin -allowSnapshot /bagol69_com/

Allowing snaphot on /bagol69_com/ succeeded

Jika sudah

berhasil mengizinkan direktory untuk

melakukan snapshot, akan terlihat

direktory tersebut.

[hadoop@localhost ~]$ hdfs lsSnapshottableDir

drwxr-xr-x 0 hadoop supergroup 0 2019-03-28 04:06 0 65536 /bagol69_com

Langsung anda

buat snapshot untuk folder

tersebut.

[hadoop@localhost ~]$ hdfs dfs -createSnapshot /bagol69_com/

Created snapshot /bagol69_com/.snapshot/s20190328-132241.547

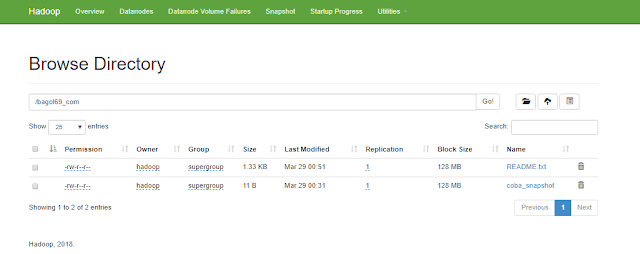

Anda dapat melihat

snapshot yang sudah

berhasil di buat, menggunakan web

manager Hadoop, seperti gambar di

bawah ini.

Baca Juga : Apa itu BIG DATA ?

PENGETESAN

Anda dapat melakukan pengetesan terhadap snapshot yang

sudah dibuat sebelumnya.

Baca Juga : Instalasi Apache Flink di Centos 7

Dengan cara hapus

salah satu file di dalam

direktory /bagol69_com/ seperti dibawah ini.

[hadoop@localhost ~]$ hdfs dfs -rm -r -skipTrash /bagol69_com/README.txt

Deleted /bagol69_com/README.txt

[hadoop@localhost ~]$

Wah sekarang

sudah tidak ada

file readme.txt di folder bagol69_com. Jangan khawatir, file tersebut

akan balik lagi, karena kita sudah

backup menggunakan fitur

snapshot hadoop.

Sekarang,

kita melakukan restore

hasil dari snapshot, untuk

membalikan file README.txt

ke folder bagol69_com.

Baca Juga : Instalasi Apache Hadoop di Centos 7

[hadoop@localhost bagol69_com]$ hadoop fs -cp /bagol69_com/.snapshot/s20190328-132241.547/README.txt /bagol69_com/

[hadoop@localhost bagol69_com]$

Alhamdulilah sudah

kembali lagi file

README.txt ke folder bagol69_com

Kesimpulan.

Anda dapat menggunakan

fitur snapshot hadoop, untuk

melakukan backup data perusahaan anda.

Tapi jangan

terlalu sering-sering melakukan

snapshot, karena akan mengurangi kemampuan hadoop untuk menyimpan data.